| CONFERENCE – Le numérique n’est pas seulement un outil, c’est un milieu, un moyen de reconditionner notre relation au monde, à la culture, à l’environnement. À l’occasion de l’ouverture du Forum des archivistes de l’AAF à Troyes, Bruno Bachimont propose ce 30 mars 2016 une conférence intitulée L’archive et la massification des données : une nouvelle raison numérique ? RESSOURCES – Une précédente conférence de Bruno Bachimont a déjà fait l’objet d’un compte-rendu ici : Le temps du document : de l’événement archivé à la mémoire préservée (2013). |

La ressource permanente et sa vue éphémère

En archivistique, on met en place des outils qui permettent de fixer dans la durée la mémoire des événements. Une trace donne lieu à un travail interprétatif de la personne qui lui fait face. La question se pose à un niveau sémiotique et culturel : nous avons besoin de notre perception pour accéder à la nature de son contenu, à travers la maîtrise des codes culturels qui forment le contexte de la trace.

À ce médium perceptif s’ajoute un médium technologique à partir du moment où la trace est codée. La ressource codée assure le rôle de permanence, mais on a besoin d’une médiation technologique pour qu’elle soit lisible, c’est la « vue publiée » (qui est dans l’éphémère de la consultation, le temps de l’ouverture du document, du travail de l’écran).

On a donc désormais affaire à un complexe documentaire. Il ne s’agit plus seulement d’avoir la clé interprétative, mais aussi la clé technique. Le numérique introduit un principe de codage universel. C’est un support anonyme parce que les suites de 0 et de 1 sont sans sémantique, elles ont besoin d’une clé de lecture externe pour être intelligibles. Un flux binaire peut être lu par des lecteurs audio ou vidéo, avec un résultat sans rapport. D’une unicité première du document, on passe à une dualité ressource permanente/vue publiée, avec la distinction donnée/visualisation. Le problème du big data, c’est que l’on sent bien que cela doit nous apporter quelque chose, mais sans toujours savoir quoi. La tension entre donnée et visualisation est récente. La donnée est le vecteur du fait humain : quel statut de l’être humain lorsqu’il est englobé dans ce big data totalisateur ?

On a donc désormais affaire à un complexe documentaire. Il ne s’agit plus seulement d’avoir la clé interprétative, mais aussi la clé technique. Le numérique introduit un principe de codage universel. C’est un support anonyme parce que les suites de 0 et de 1 sont sans sémantique, elles ont besoin d’une clé de lecture externe pour être intelligibles. Un flux binaire peut être lu par des lecteurs audio ou vidéo, avec un résultat sans rapport. D’une unicité première du document, on passe à une dualité ressource permanente/vue publiée, avec la distinction donnée/visualisation. Le problème du big data, c’est que l’on sent bien que cela doit nous apporter quelque chose, mais sans toujours savoir quoi. La tension entre donnée et visualisation est récente. La donnée est le vecteur du fait humain : quel statut de l’être humain lorsqu’il est englobé dans ce big data totalisateur ?

Le cadre de la conférence: le Forum des archivistes, à Troyes.

Nominalismes et variantes

Bruno Bachimont rappelle les leçons de nominalisme de Guillaume de Baskerville au novice Adso de Melk dans Le Nom de la Rose d’Umberto Eco. Selon le réalisme médiéval, lorsqu’on a une phrase bien construite, l’agencement syntaxique de la phrase reflète l’agencement du monde. Le nominalisme médiéval critique cette vision : il n’y a pas à rechercher dans les lois du langage les lois du monde. Cette nouvelle relation entre la pensée et la nature est couronnée par la révolution galileo-cartésienne.

Aujourd’hui, le big data est porteur d’une nouvelle révolution nominaliste : la relation du mot au fait humain. Désormais on a plus besoin de lire nous-mêmes les documents, on les rassemble en masse pour les calculer. Au lieu d’avoir un rapport à la culture qui repose sur la langue et la compréhension de l’humain, cette relation fondée sur le calcul. Avec le numérique, nous avons des masses considérables qui donnent au paradigme calculatoire un grand terrain de jeu inédit.

Le numérique a commencé comme une belle histoire, une bonne nouvelle. Le binaire semblait la solution parfaite : il permet de faire des copies parfaites, au bit près, de pallier à la corruption des supports, portant le fantasme du document ubiquitaire et éternel, des données homogènes. Mais, « le numérique est le pire des supports, mais on n’en connais pas de meilleur », affirme Bachimont, parodiant Churchill.

Ce rapport entre ressource et variantes a pour conséquence que l’on ne voit jamais deux fois de suite de la même manière le même document. Hors de l’immuabilité parménidienne, nous sommes dans le flux héraclitéen, on ne se baigne jamais deux fois dans le même flux. Quels principes interprétatifs et philologiques nous permettent-ils de déterminer, à la vue de deux vidéos reprises dans des émissions TV différentes, quelle vidéo est l’originale ? La seule intégrité sur laquelle on peut se baser, c’est la vue. Il ne faut plus essayer de relier la variante à une origine, puisqu’on sait que c’est toujours une reconstruction (par ex. pour un site web, dont tous les contenus sont sollicités uniquement quand on y navigue).

Big data : impossible création de nouvelle connaissance ?

Cela fait 40 ans que les informaticiens s’escriment pour interpréter et conserver des grandes masses de données, raison pour laquelle il ne faut pas confondre big data et “masse de données”. Le big data, c’est la gestion dynamique de données hétérogènes. Le web étant un support sans sémantique, on peut y homogénéiser des données hétérogènes : le numérique « oublie tout » en transcrivant les données en 0 et en 1.

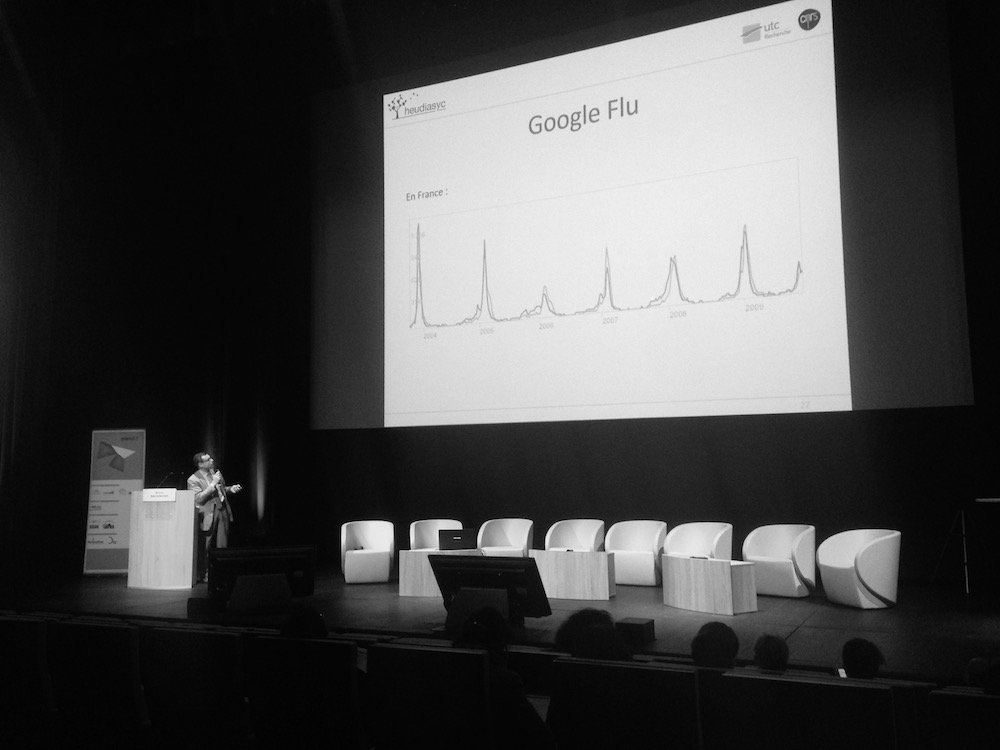

Bruno Bachimont propose l’exemple du projet de Google de répertorier les épidémies de grippe (ci-contre). La superposition quasi-parfaite des deux courbes de grippe (épidémiologique officielle et Google) pourrait laisser croire qu’il n’est plus besoin de faire de l’épidémiologie, mais qu’il suffit de s’intéresser aux tendances d’apparition de certains mots dans les médias. MAIS : quand on y regarde de plus près, on se rend compte que Google surestime très souvent le phénomène réel, parce que les médias et l’Internet amplifient ce genre d’information ou de rumeur.

Bruno Bachimont propose l’exemple du projet de Google de répertorier les épidémies de grippe (ci-contre). La superposition quasi-parfaite des deux courbes de grippe (épidémiologique officielle et Google) pourrait laisser croire qu’il n’est plus besoin de faire de l’épidémiologie, mais qu’il suffit de s’intéresser aux tendances d’apparition de certains mots dans les médias. MAIS : quand on y regarde de plus près, on se rend compte que Google surestime très souvent le phénomène réel, parce que les médias et l’Internet amplifient ce genre d’information ou de rumeur.

On nous dit que la données est une mesure mise dans un ordinateur. C’est un sophisme. Qu’est-ce qu’une « donnée » ? Quelque chose qui est « donnée » par un tiers, qui est construit ! Ce ne sont donc pas des données, ce sont des « construits » (Bruno Latour) ou des « capta » (Johanna Drucker). Dans le big data, le traitement des données n’a rien à voir avec leur obtention. C’est la première fois qu’on a une rupture entre production et interprétation de la donnée. En sciences expérimentales, on a(vait) une continuité entre l’expérience (la production de données) et l’interprétation. Ici, on perd le lien avec l’origine, d’ailleurs cela n’a pas beaucoup d’importance puisqu’on observe la récurrence statistique.

Comment passer de l’épistémologie de la mesure à une épistémologie de la donnée ? Il ne s’agit pas de dire que le big data ne comporte pas des points positifs, mais que cela n’est pas ce qu’on nous dit. Ce n’est pas comparable à ce qu’on faisait jusqu’alors. Il en va de même pour la visualisation : les outils lisent pour nous les informations. Un graphe montre de très belles choses, mais on ne peut pas s’empêcher de donner du sens à ce qu’on voit. On donne du sens aux couleurs, aux clusters, mais si on est pas tout à fait au fait de la construction du graphe, il est impossible à interpréter. Ce qui arrive à la visualisation scientifique de l’astronomie est tout à fait analogue à la visualisation de données : la reconstruction de “photographies de galaxies” sur la base de données de mesure nous donne à voir une représentation parmi beaucoup d’autres, pas une photographie en tant que telle.

Le problème, c’est que le nominalisme de la donnée remplace les outils habituels de la compréhension du fait humain, qui repose sur le témoignage, la mise en série, etc. Avec comme paradoxe qu’en utilisant le big data, on s’interdit de comprendre le fait humain, on documente très souvent ce que l’on sait déjà.

Le problème, c’est que le nominalisme de la donnée remplace les outils habituels de la compréhension du fait humain, qui repose sur le témoignage, la mise en série, etc. Avec comme paradoxe qu’en utilisant le big data, on s’interdit de comprendre le fait humain, on documente très souvent ce que l’on sait déjà.

C’est le paradoxe du Ménon de Platon : on ne peut jamais connaître quelque chose de nouveau puisque si ce quelque chose est réellement nouveau, on va passer à côté parce qu’on ne le connaît pas et que l’on a pas les moyens de se rendre compte qu’on l’a découvert…

Trackbacks/Pingbacks